謝賽寧緊急辟謠:Sora跟我一點關系沒有、他們996搞一年了

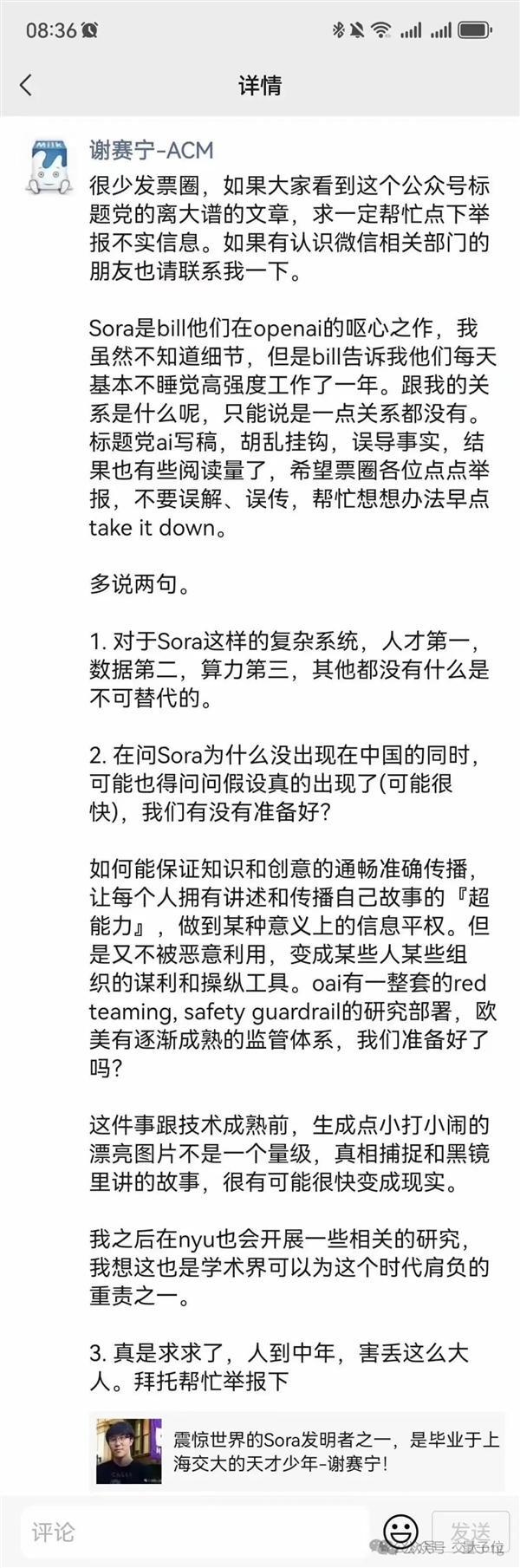

誤會了誤會了,被傳為“Sora作者之一”的上交大校友謝賽寧,本人緊急辟謠。

他的聲明發在其朋友圈,以及“交大校友薈”賬號交大org上,主要說了幾點:

Sora完全是OpenAI的工作,和謝賽寧本人一點關系沒有。

但他后面將在紐約大學開展相關研究

要開發Sora這樣的成果,人才第一, 數據第二,算力第三。

《黑鏡》等科幻作品里的部分故事可能很快成為現實,需要準備好對應的監督體系。

傳播不實信息的原文章也在大家幫忙舉報后被平臺下架了。

這番誤會終于算是告一段落。

不過謝賽寧透露的信息中還有一些細節值得關注,相熟的Sora開發領隊Bill Peebles說團隊基本不睡覺高強度工作了近一年。

而Bill Peebles在2023年3月入職OpenAI,距今剛好不到一年。

也從側面否定了之前傳聞中的“Sora早就開發完成,只是一直沒發”。

至于為什么會有這個離譜的誤會,還要從謝賽寧與Peebles合作的一篇論文說起。

為什么會有這個誤會?

Sora技術報告引用的一項研究成果DiT模型,正是謝賽寧與Peebles合著。

那時Peebles博士在讀期間到Meta實習,謝賽寧也還沒完全離開FAIR。

DiT首次將Transformer與擴散模型結合到了一起,相關論文被ICCV 2023錄用為Oral論文。

雖然Sora模型具體架構細節沒有公布,但謝賽寧此前從Sora技術報告中分析出出,很可能就是建立在DiT的基礎之上。

除此之外,Sora還參考借鑒了許多其他學術界成果。

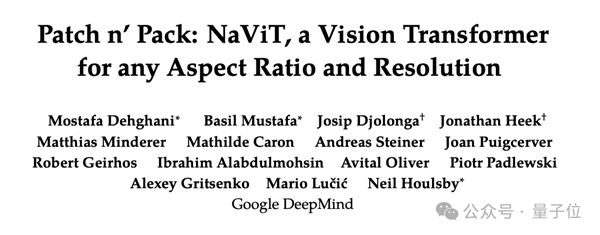

如把訓練數據編碼成Patch的方法,引用了谷歌DeepMind的Patch n’ Pack等。

博采眾長,同時堅定在Scaling Law指引下力大磚飛,才造了令人驚嘆的Sora成果。

大神確實也是大神

排除掉這個誤會,謝賽寧確實也是AI研究領域的一位大神,目前在紐約大學任助理教授。

他本科畢業于上海交通大學ACM班,18年博士畢業于加州大學圣迭戈分校。

畢業后謝賽寧加入Facebook AI Research(FAIR),曾與何愷明合作提出ResNeXt。

目前他在谷歌學術總被引用數達到4萬5,h-index也高達31。

就在Sora發布不久前,他還領導紐約大學團隊對DiT模型來了個大升級,新模型稱為SiT。

SiT與DiT擁有相同的骨干網絡,但質量、速度靈活性都更好。

謝賽寧認為,跟進Sora相關研究是學術界可以為這個時代肩負的重責之一。

讓我們一起期待他的新成果吧。

參考鏈接:[1]https://mp.weixin.qq.com/s/4ox9ITnd8TE2_Sior3eaEA

本站所有文章、數據、圖片均來自互聯網,一切版權均歸源網站或源作者所有。

如果侵犯了你的權益請來信告知我們刪除。郵箱:business@qudong.com