媲美GPT-4的開源模型泄露!正式版本還會更強

Mistral-Medium竟然意外泄露?此前僅能通過API獲得,性能直逼GPT-4。

CEO最新發聲:確有其事,系早期客戶員工泄露。但仍表示敬請期待。

換句話說,這個版本尚且還是舊的,實際版本性能還會更好。

這兩天,這個名叫“Miqu”的神秘模型在大模型社區里炸了鍋,不少人還懷疑這是LIama的微調版本。

對此Mistral CEO也做出了解釋, Mistral Medium是在Llama 2基礎上重新訓練的,因為需盡快向早期客戶提供更接近GPT-4性能的API, 預訓練在Mistral 7B發布當天完成。

如今真相大白,CEO還賣關子,不少網友在底下戳戳手期待。

Mistral-Medium意外泄露

我們還是重新來回顧一下整個事件。1月28日,一個名叫Miqu Dev的神秘用戶在HuggingFace上發布一組文件“miqu-1-70b”。

文件指出新LLM的“提示格式”以及用戶交互方式同Mistral相同。

同一天,4chan上一個匿名用戶發布了關于miqu-1-70b文件的鏈接。

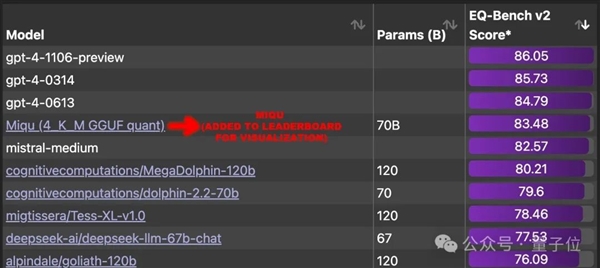

于是乎一些網友注意到了這個神秘的模型,并且開始進行一些基準測試。

結果驚人發現,它在EQ-Bench 上獲得83.5 分(本地評估),超過世界上除GPT-4之外的所有其他大模型。

一時間,網友們強烈呼吁將這個大模型添加到排行榜中,并且找出背后的真實模型。

大致懷疑方向主要有三個:

與Mistral-Medium是同一個模型。

有網友曬出了對比效果:它知道標準答案還說得過去,但不可能連俄語措辭也跟Mistral-Medium完全相同吧。

Miqu應該是LIama 2的微調版本。

但另外的網友發現,它并不是MoE模型,并且同LIama 2架構相同、參數相同、層數相同,。

不過馬上就受到其他網友的質疑,Mistral 7b也具有與 llama 7B 相同的參數和層數。

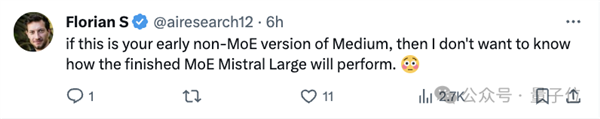

相反,這更像是Mistral早期非MoE版本模型。

不過討論來討論去,不可否認的是在不少人心中,這已經是最接近GPT-4的模型了。

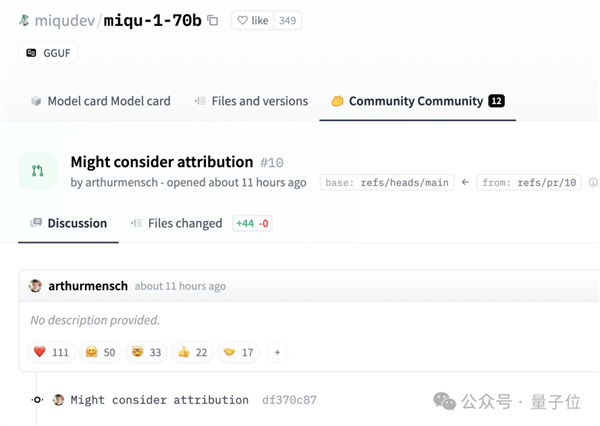

如今,Mistral 聯合創始人兼首席執行官 Arthur Mensch承認泄露,是他們一位早期客戶員工過于熱情,泄露了他們訓練并公開發布的一個舊模型量化版本。

至于Perplexity這邊CEO也澄清說,他們從未獲得過Mistral Medium的權重。

網友擔心是否會撤下這個版本。

有趣的是,Mensch并沒有要求刪除HuggingFace上的帖子。

而是留下評論說:可能會考慮歸屬問題。

參考鏈接:

[1]https://www.reddit.com/r/LocalLLaMA/comments/1af4fbg/llm_comparisontest_miqu170b/

[2]https://twitter.com/teortaxesTex/status/1752427812466593975

[3]https://twitter.com/N8Programs/status/1752441060133892503

[4]https://twitter.com/AravSrinivas/status/1752803571035504858

本站所有文章、數據、圖片均來自互聯網,一切版權均歸源網站或源作者所有。

如果侵犯了你的權益請來信告知我們刪除。郵箱:business@qudong.com