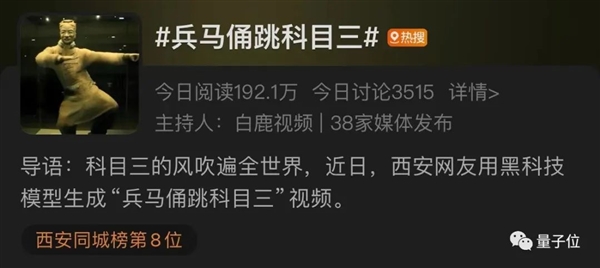

兵馬俑跳《科目三》 是我萬沒想到的

家人們,火爆全球的魔性舞蹈《科目三》,誰能料到,就連兵馬俑也開始跳上了!

熱度還居高不下,瞬間被轟上了熱搜,小伙伴們紛紛驚掉了下巴表示“聞所未聞,見所未見”。

這到底是怎么一回事?

原來,是有人借助了阿里之前走紅的AI技術(shù)——AnimateAnyone,生成出來了這個舞蹈片段。

技術(shù)圈的盆友對這個技術(shù)都不陌生,“出道”至今僅僅1個月時間,這個項目便已經(jīng)在GitHub上斬獲了超1.1萬個star。

呼喚它能讓更多人輕松上手體驗的聲音,也越來越多。

好消息是,現(xiàn)在AnimateAnyone已經(jīng)可以免費體驗了!

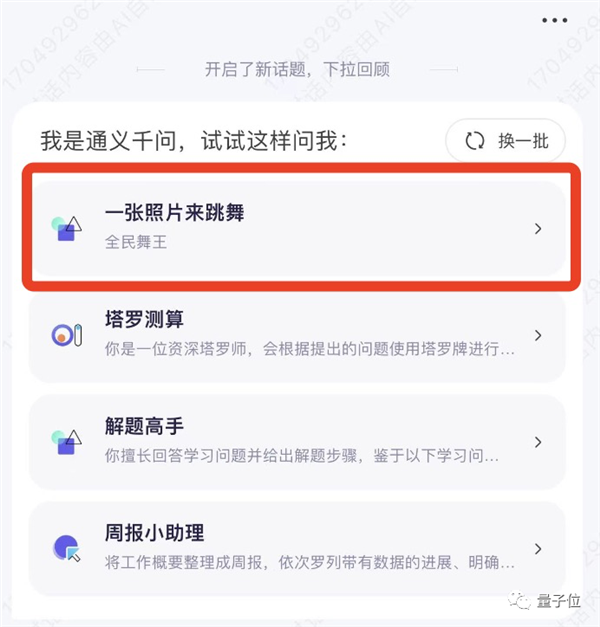

而且“入口”還直接被嵌進了阿里通義千問APP——名曰:通義舞王。

很快,各種效果、各種玩法、各種人物,都動了起來……例如微博網(wǎng)友“Simon_阿文”,讓拿破侖表演了一把……

這標致的舞姿,這反差的形象,著實算是把腦洞給打開了。

也有不少網(wǎng)友換了個思路:

想用自己照片試試;以后投宅舞視頻可以直接生成了。

所以效果究竟行不行,我們也忍不住實測了一波~

讓貝佐斯舞一段《極樂凈土》

打開通義千問APP,我們只需要點擊對話框中的“一張照片來跳舞”:

或者在輸入框內(nèi)敲“通義舞王”或“全民舞王”等關(guān)鍵詞,就可以跳轉(zhuǎn)到相應(yīng)界面了:

接下來的操作,也正如我們剛才所說:極、其、簡、單。

首先,在眾多已經(jīng)提供的模板中,pick一個。

目前通義千問APP提供了12個模板,這次我們就選擇二次元最愛、宅舞《極樂凈土》測試一下~

然后,選一位測試對象。比如我們找了(前)全球首富貝佐斯:

需要說明的是,在選擇照片的時候,還是需要一點“技巧”的,“通義舞王”也有相應(yīng)提示:

正面站立

全身照

全身無遮擋

無仰俯角

在此之后,直接點擊“立即生成”,靜候幾分鐘,貝佐斯大跳《極樂凈土》的視頻,就誕生了:

是不是效果還行?雖然還不能講“真假難辨”,但首富都能這樣為你跳一曲了,還要什么自行車。

不僅如此,“通義舞王”除了能夠生成真人風格之外,還有其他風格可玩。

例如動漫風格的小姐姐跳DJ慢搖:

還有卡通風格的人物熱舞:

總而言之,現(xiàn)在你想讓任何人跳舞——一張全身照就夠了。

不過有一說一,雖然“通義舞王”已經(jīng)成功吸引了眾多網(wǎng)友前來玩耍,反響火爆,但它也還沒到完美無瑕的境界。

例如等待時長,現(xiàn)在平均時間大約在10分鐘左右(有點久,但畢竟是免費的,還要啥自行車啊)。

還有就是從視頻效果來看,如果照片角度不好或者清晰度不夠也會影響AI對于人物手部的處理。

這些問題,實際都與背后的技術(shù)原理和技術(shù)挑戰(zhàn),密不可分。

怎么做到的?

在視覺生成任務(wù)中,目前較為主流的方法便是擴散模型。

但在僅靠一張照片就生成視頻這件事上,它還面臨著諸多的挑戰(zhàn),例如人物形象一致性(consistency)的問題。

簡單來說,就是如何保證照片人物在動起來的過程中,各種細節(jié)能夠和原照片保持一致。

為此,阿里團隊在擴散模型的基礎(chǔ)之上,提出了一個新的算法,也就是我們剛才提到的AnimateAnyone。

從一致性、可控性和穩(wěn)定性三個方面,保證了視頻輸出的效果和質(zhì)量。

例如在一致性方面,阿里團隊引入的是ReferenceNet,用于捕捉和保留原圖像信息,可高度還原人物、表情及服裝細節(jié)。

具體而言,在參考圖特征提取上,ReferenceNet采用的是與去噪UNet類似的框架,但沒有包含時間層;它繼承了原始擴散模型的權(quán)重,并獨立進行權(quán)重更新。

在將ReferenceNet的特征融合到去噪UNet時,首先將來自ReferenceNet的特征圖x2復(fù)制t次,并與去噪UNet的特征圖x1沿w維度連接;然后進行自注意力處理,并提取特征圖的前半部分作為輸出。

雖然ReferenceNet引入了與去噪UNet相當數(shù)量的參數(shù),但在基于擴散的視頻生成中,所有視頻幀都需要多次去噪,而ReferenceNet只需在整個過程中提取一次特征,因此在推理過程中不會導(dǎo)致顯著增加計算開銷。

在可控性方面,阿里團隊使用的是Pose Guider姿態(tài)引導(dǎo)器。

Pose Guider姿勢引導(dǎo)器采用的是一個輕量級設(shè)計,而不是引入一個額外的控制網(wǎng)絡(luò)。

具體來說,使用了四個卷積層(卷積核大小為4 x 4,步幅為2×2,通道數(shù)分別為16、32、64、128),這些卷積層用于將姿勢圖像對齊到與噪聲潛變量相同的分辨率。

處理后的姿勢圖像會被加到噪聲潛變量上,然后一起輸入到去噪UNet中,從而在不顯著增加計算復(fù)雜性的情況下,為去噪UNet提供姿勢控制。

最后是在穩(wěn)定性方面,阿里團隊引入的是一個時序生成模塊。

時序?qū)拥脑O(shè)計靈感來源于AnimateDiff,通過在特征圖上執(zhí)行時間維度的自注意力,以及通過殘差連接,其特征被整合到原始特征中。

同樣的,這個模塊的作用之下,滿足了在保持時間連續(xù)性和細節(jié)平滑性的同時,減少了對復(fù)雜運動建模的需求。

最終,在AnimateAnyone的加持之下,從效果上來看,保證了圖像與視頻中人物的一致性。

這也是AnimateAnyone背后的技術(shù)原理。

然而,阿里之所以不斷在AnimateAnyone上攻堅優(yōu)化,并非完全出于技術(shù)很酷很有潛力,還藏著一顆引領(lǐng)視頻生成技術(shù)的野心。

因為大家都在問“What is the Next?”的時候,LVM(Large Vision Model),已經(jīng)潮水聲轟鳴了。

What is the Next?實際上,在AnimateAnyone火了之后,阿里還有另一項視頻生成技術(shù)在同時出圈。

它叫DreaMoving,只需一張臉部照片、一句話描述,就能讓你在任何地方跳舞!

例如下面這段《擦玻璃》的舞蹈視頻:

你所需要做的就是“投喂”一張人像,以及一段prompt:

一個女孩,微笑著,在秋天的金色樹葉中跳舞,穿著淺藍色的連衣裙。

而且隨著prompt的變化,人物背景和身上的衣服也會隨之發(fā)生改變。例如我們再換兩句:

一個女孩,微笑著,在木屋里跳舞,穿著毛衣和長褲。

一個女孩,微笑著,在時代廣場跳舞,穿著連衣裙般的白襯衫,長袖,長褲。

和AnimateAnyone一樣的,它也是真人、卡通、動漫人物統(tǒng)統(tǒng)都能hold住。

當時也引來了不少網(wǎng)友們的熱玩和驚呼。

這些都是阿里在視頻生成上的“沿途下蛋”,都是“勇攀珠峰”——死磕AI視頻生成技術(shù)的證明和結(jié)果。

為什么?

因為縱觀去年一整年的AIGC發(fā)展的脈絡(luò),AI視頻生成的爆發(fā)趨勢似乎越來越明確了。

2022年底以來,從最初ChatGPT引爆大語言模型,全球科技巨頭乃至初創(chuàng)企業(yè)紛紛入局,到后來各家不僅限于自然語言技術(shù),更是將文生圖、文生音頻、文生視頻、圖生視頻等多模態(tài)技術(shù)“玩”出了新高度。

產(chǎn)業(yè)是什么?LLM(大語言模型)正在逐步向LMM(多模態(tài)大模型)發(fā)展。

并且從這期間學術(shù)界、產(chǎn)業(yè)界所交出的一份份“作業(yè)”中,也能印證這一點:

Pika1.0發(fā)布,剛出道就成行業(yè)頂流,引來一眾大佬圍觀;

Runway家升級Gen2,分分鐘打造高質(zhì)量小電影;

李飛飛W.A.L.T緊隨其后,同樣也是發(fā)力于此;

谷歌Gemini發(fā)布現(xiàn)場,大秀多種模態(tài)的聯(lián)動玩法。

因此,多模態(tài)大模型、AI視頻生成領(lǐng)域,正是現(xiàn)如今AIGC這波頂流中的頂流,阿里頻頻在此發(fā)力,也就不難理解了。

不僅如此,在歲末年初之際,更是有眾多AI大佬將2024年的預(yù)測押注于此。

例如Meta研究院Martin Signoux非常直接地表態(tài)“再見LLM,你好LMM”,這個預(yù)測也得到了LeCun的轉(zhuǎn)發(fā)和點贊。

因此,如果要問誰是下一個ChatGPT,可能沒有人可以給出準確預(yù)判。

但如果問下一個ChatGPT會從哪個賽道來?AI視頻生成,就是自帶鼓風機的那一個,而在這個賽道里,阿里已經(jīng)搶占了先機。

參考鏈接:[1]https://weibo.com/1757693565/NA6OhoCo2#comment[2]https://weibo.com/2099591797/NA8fX0eOE?refer_flag=1001030103_

本站所有文章、數(shù)據(jù)、圖片均來自互聯(lián)網(wǎng),一切版權(quán)均歸源網(wǎng)站或源作者所有。

如果侵犯了你的權(quán)益請來信告知我們刪除。郵箱:business@qudong.com